又到财报季,AI芯片公司营收怎么样?

偷懒了几个月,其实,也没有。

自去年 11 月 30 日

ChatGPT惊艳亮相,转眼间就一年了。这一年来,AI世界的变化真的让人眼花缭乱,要保持跟上如此高的新知识、技术的演进节奏与快速变化,但愿大家的头发都还好。过去搞算法的都觉得

CV卷,但是从AlexNet到ResNet到EffcientNet差不多有 7 年的时间跨度。看看这一年与大模型相关的论文、项目,知识的更新\过时速度几乎要以周为单位了,真心学不过来啊。所以,就

专心摸鱼持续调研,认真学习领域技术和趋势发展,避免说外行话,以免别人说个新名词,一脸茫然。

前一阵在朋友圈看到某大佬调侃了一句:“都在拿nv做baseline~ 然后发现这个baseline各不相同”。

想不到啊想不到啊,关于“友商”的baseline各不相同这件事,在AMD和NVIDIA之间也出现了“神仙打架”。

这个故事,相信大家从很多公众号都能看到,我也不多说了。真没注意到的,事情其实就三句话说完了:

AMD的发布会,放了一个MI300X对比H100的性能数据,有点优势,但不大,算是“小赢”;过几天

NVIDIA在自己官方博客上又放了一个文章,对比数据从“被友商小赢”反转为“对友商的碾压优势”;然后,第二天

AMD也丢出了一个文章(应该是出离愤怒了,从分析数据到做实验到写文章,一天搞定),指出对比不当的问题,对比数据变成了“大赢”,然后还补刀“在不断优化,发布会的数据是11月的,到目前已经取得了很大的进展”。

从吃瓜不嫌事大的角度来说,NVIDIA即使对AMD的数据有质疑,不服气,但是拿FP8的性能对对比人家FP16的数据,这一点确实有那么一点点“向上管理”的味道了(我是不太相信技术人员对这种对比不合理是没有认知的,估计是LD要结果,所以……)。

发布会的内容,铺天盖地的,就放两个互撕的原文链接,大家自己去看吧,怎么看这事情,自己判断吧。

Achieving Top Inference Performance with the NVIDIA H100 Tensor Core GPU and NVIDIA TensorRT-LLM

Competitive performance claims and industry leading Inference performance on AMD Instinct MI300X

看热闹归看热闹,但是一个细节还是挺有意思。

打败魔法的魔法究竟是什么魔法

AMD与NVIDIA的魔法对决

接着说AMD发布会上秀出的数据和与H100的对比数据,就捡重要的说:Memory Bandwidth与推理性能。

先看基本数据。

| A100 SXM | H100 SXM | H200 SXM | MI300X | |

|---|---|---|---|---|

| 带宽 | 2.039TB/s | 3.35 TB/s | 4.8 TB/s | 5.3TB/s |

| 容量 | 80GB | 80GB | 141GB | 192GB |

带宽的提升比率是。

| H100 vs A100 | H200 vs H100 | MI300X vs H100 |

|---|---|---|

| 1.64 | 1.43 | 1.58 |

好了,文不如表,表不如图,就放两家性能对比图吧。

图源:NVIDIA H200 Tensor Core GPU

图源:AMD MI300 Performance - Faster Than H100, But How Much?

由于对于测试的基准、方法、参数不一定一致,所以这种对比结果会有偏差的,只能简单理解一下这个性能提升数据的意义,不一定对。

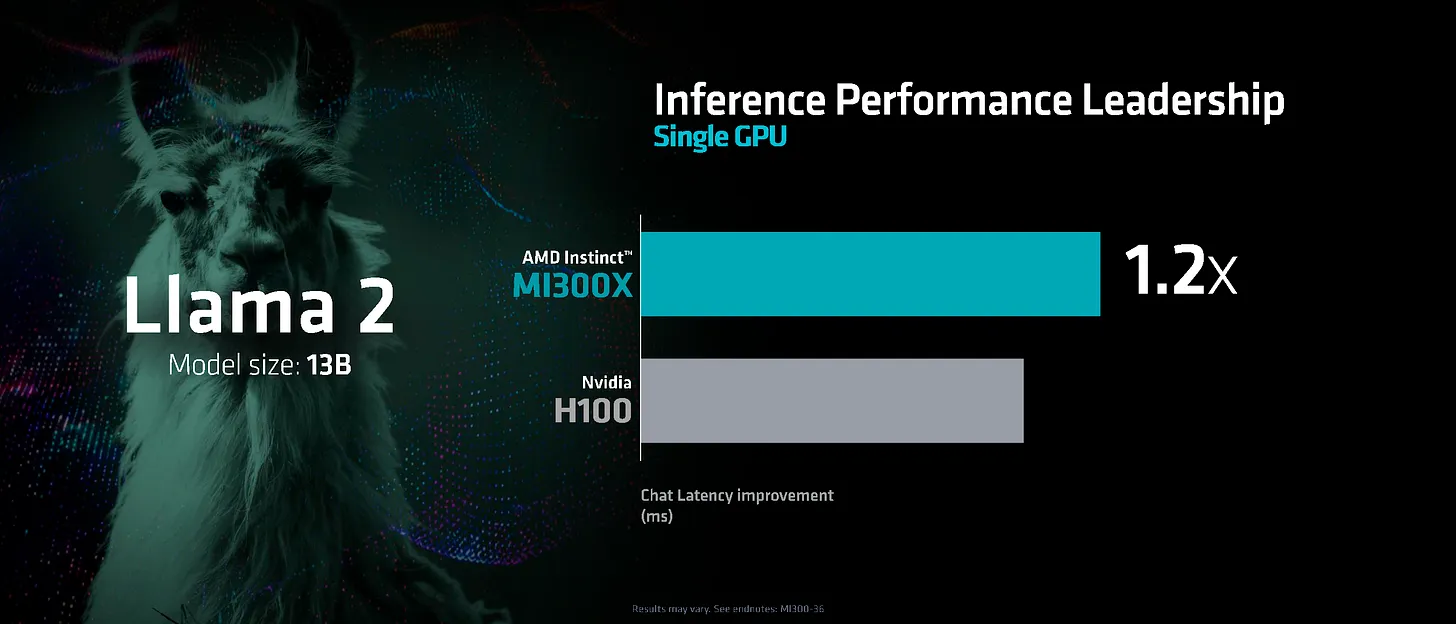

我们只看Llama2 13B的性能对比,因为这个参数量单卡就能装下,不涉及多卡,事情就简单一点。

-

H200用 1.43 倍的带宽提升,换来了对比H100的 1.4X 倍的推理性能提升; MI300X用 1.58 倍的带宽提升,换来了对比H100的 1.2 倍的推理性能提升;H100用 1.64 倍的带宽提升,换来了对比A100的 1.65 倍的推理性能提升(BS=1);

H100对比A100的数据没找到基于Llama2 13B的这样简单粗暴又直观的性能对比图。但是,数据还是替大家弄一个,显然不是我跑的,我这种穷人,哪里有资格拿H100跑数据玩?数据是在NeMo Framework User Guide里发现的。

结论还要说么?要说么?

在单卡这种优化空间和手段有限的情况下,就算黄教主能拿到的性能提升,也是HBM给的,离开HBM那就啥也没有。

古人曰:What Andy gives, Bill takes.

现在是不是到了:What Jensen wants,HBM gives.

在AI芯片领域,CUDA生态这个护城河大家都听烦了,但是,这河有多宽?AMD的一个“不小心”给出了最好的注解:ROCm用1.58的带宽提升,只干出来1.2倍的单卡性能提升,显然是软件还没有把显存带宽全部压榨干净啊。

相同技术参数下,人家软硬件整体优化的底子还是很厚实的,轻松榨干硬件带来的性能收益,“赢”的理论基础不存在,“打平”已经是上限了。

要是上集群,人家再拿出来NVLink、NVSwitch与IB,软硬网结合,优化空间更大了,跟着Nvidia的路子走的“魔法”真能打败人家的魔法组合么?

软件的路任重道远,对于能怼出来堪称工程奇迹的Chiplet的AMD也一样。

看起来,HBM虽然很香,暂时还不是那个能“打败”魔法的魔法。

Groq与NVIDIA的魔法对决

换个路子看看是不是打败魔法的魔法。

Groq大家应该不陌生,下半年“悄咪咪”的做了两件大事,其实也就是一件事:自己的记录自己反手破了而已。三个月性能提升三倍,这个优化收益真是相当可以的。

Groq怎么做到的,我就不啰嗦了,大家可以看看这个文章:GROQ SAYS IT CAN DEPLOY 1 MILLION AI INFERENCE CHIPS IN TWO YEARS

至于这个300 Tokens/s性能怎么样,实在没找到H100的参考数据,前面提到的A100和H100推理性能对比数据可以拿来参考下。

要知道Groq的GroqChip用的是14 nm工艺,跑出来这个数据,他魔法是什么?

-

230 MB的片上SRAM,片外也没有用DRAM -

芯片间的光互联总带宽

330 GB/s

别的也就不算魔法范畴了吧。

要问230 MB的片上SRAM怎么跑70B这样巨大的模型?答案就是:他们放出来的数据的测试环境中堆了576张卡。

对了Groq的Demo页可以公开访问了chat.groq.com,大家可以去感受下300 tokens per second per user速度与激情的快乐与震撼。

BTW,其实 MI300X有256MB的 L3 Cache,说实话真不小了,应该还是没用好。

可能存在的魔法会是什么

一句废话:现阶段及可预见的一段时间内大模型训练、推理所需要最关键的银弹就是:“Memory Bandwidth”。

GDDR7容量大还便宜,但是内存带宽的上限目前看还是太低了,GDDR7带宽能不能再大点,只能等待唯三的供应商加加油。

SRAM很容量小且“贵”,HBM3e容量大但很贵,还不一定拿到产能,目前成熟方案似乎只有这两了。

前几年大家搞AI芯片,解决的核心问题是compute bound。

先把编程模型和软件的问题丢一边,单说堆峰值算力解决compute bound还是有很多解的。不管是做ASIC还是DSA还是GPGPU的技术路线,起码大家都在ResNet50上把“友商的主流产品”当作背景板在PPT和“手工调优”的代码中反复摩擦了。

提了Groq不提Tenstorrent是不合适的。Tenstorrent也是架构创新的好学生,而且他曾经用RN50把Groq和NVIDIA放一起同时当背景板的。在大模型时代Tenstorrent跑Llama2 70B的性能数据,还是等Jim Keller啥时候出来讲讲了。

不管兼容不兼容CUDA,走什么技术路线,似乎大家在大模型领域,依然有决心“超越友商”。

决心是决心,魔法是魔法。还是先召唤神龙吧。

对于Memory Bandwidth Bound这件事,现阶段MoE看起来是个解(但是,batch size大了之后,可能MoE可能会退化成一个“大模型”的参数量的访存)。“大模型”变“小模型”看起来也是条路子,但是,从逻辑上说13B干过70B更有可能的原因是70B不够强。

还有,W8A16、W8A8等等这些方案,都是可以降低对DRAM带宽和容量需求。但是,这些模型层面上的方法创新,是AI芯片行业的福利,大家一起享受,一起进步,一起躺赚。

所以,模型性能上的创新甚至结构的颠覆性改变,这些不是我们讨论的重点。

-

存算肯定是个路子。但,要解决好存算的“算”这一部分算不了的计算,用什么技术路线做兜底计算,关键要能配得上存算部分的吞吐能力。

-

私有协议的光互联显然是个路子。但,做到

TPU的那个手艺,估计也不是那么容易的。 -

3D封装也是个路子。把价格便宜量又足的DRAM直接怼到计算Die的二楼去,800平的大平层瞬间变叠拼别墅,带宽狂飙了,散热么,可能要想想办法咯。 -

反正大模型的计算强度有限,把算力的面积拿出来给

SRAM也是个路子,跟着Groq走,让谁无路可走呢?

不负责的猜测,或许很快可以看到这样一个面向大模型的芯片产品:

1)

LPDDR5X+HBM3e+SRAM组成一个“三级”存储形态,通过软件的抽象,对外表现出拥有巨大容量与高带宽,且成本更友好的片外存储形态;且,2)具有可配置,可路由,东南西北向

4出的高带宽的片间光互联;且,3)有与片间互联协议与带宽匹配的光交换机;且,

4)具有硬化的

Transformer Engine、Beam Search、MCTS这些ASIC计算核心;且,5)与已经干到

700W以上的能耗大户相比,有“极低”功耗,且,6)不论吞吐量还是延时,都有足够的整体优势;且,

7)有非常非常非常牛逼的系统工程团队与软件工程团队。

毕竟只有 TCO 的帐能算明白,才能实现真正的“商业化”。

前面这部分算是补个作业,把前几个月偷懒的事情搞完。

下面回到主题。

大家的营收目标达成了么?

说实话,我不知道:既不知道营收目标,也不知道实际收入。

今年大家都非常非常低调,毕竟“实体清单”的规则似乎很难揣测。

知道的越少越好。

事实上,今年就两个“热点”:大模型与智算中心。运营商么,大家测归测,测了一轮又一轮,测完好像就测完了。

大模型

先说大模型吧。好巧不巧,去年的那篇是11月21日写的,正好赶在ChatGPT之前,哪曾想到今年会是一个大家All in AIGC的局面。

说到All in,一家想都没想到的,基本从有消息就是负面,到基本上听不到消息的,居然突然就发布了“基于开源指令架构RISC-V打造的大模型系列一体机”,刷到公众号的文章的时候真的愣了一下。

因为,我要是没记错的话,他们的卡用的是LPDDR4,这带宽跑7B、13B,嗯,也不是不能跑,对吧。

年中的时候,有人问过这一波大模型的机会,哪家会机会大一点。

我给的答案是“两家”。

理由很简单,当时量产的,且软件也七七八八能用的,关键是有HBM2以上规格的DRAM,只有这两家啊(按照惯例,在讨论国产的话题的时候,遥遥领先都是单独存在,不能放在一起说)。

大模型,尤其是关注度最高的类ChatGPT模型,结构是那么的规整,算子就那几个,内存带宽优势明显,一家有互联,一家没互联,要这机会白给的机会都能错过,那也太说不过过去了吧?

事实上,这两家确实也是发了大力,不管是WAIC上秀出来的,还是出去讲的PPT内容,可以看出来,信心那是满满的。

至于,实际上的收入么。各种消息都有,我也不知道面对差距很大消息,怎么筛选。就当不知道好了。

除了这两家,其余厂商的竞争力,说实话看看DRAM型号,不管公开不公开“内存带宽”的具体数据,以我小学数学满分💯的功底,也能算出来,更别说,大家都有更专业同学在研究友商了。

话说回来,理论是理论,软件能不能跑出来那是另一回事。

听到某家我还比较看好的友商的Llama2的性能,我真的沉默了,太意外了,意外到不太理解这数据的真实性,不太像CV领域他们在圈内的软件口碑与跑出来的数据。但愿,我听到的是假消息,是在放烟雾弹吧。

当然,技术是技术,商务是商务。只要能用,一定有人能卖出去,这个毫无疑问。

智算中心

智算这个市场,《算力基础设施高质量发展行动计划》已经指明了方向,目前肯定应该是所有AI芯片公司的第一重点市场,没有之一。

时不时就有哪里有项目,谁谁谁可能中了,真真假假。要核实一个消息,有时候真难。

不过,真关心友商是不是搞定“大项目”了,去专门搜招标/中标的平台搜呗。只要搜的好,答案自然有,不过这些平台的会员价真不是个人可以承受的,MTK同学还是做进明年的市场预算吧。当然,有些地方项目,不一定能搜到结果,比如某司的南边的某个项目,我就搜不到。

大项目有大项目的好,大项目有大项目的难,说不定忙来忙去给黄老板打工了。

一个项目能做出来几个亿收入,多少人盯着,哪里那么简单就拿下对吧。当然,也有可能出现不可控的情况,做好的“局”给别人摘了桃子。但说实话,这种桃子好摘,不一定不好吃。

反正,不管知道不知道。智算中心项目今年确实为行业贡献了很大的收入,对个别家很有可能一单就是全年收入的90%了。

所以,目标达成多少,就看有没有拿下智算了。

大模型,确实有机会,也有落单的,但是量还是太小,对于“完成销售目标”这个宏大的主题来说,还是属于布局中的市场。

未来会怎样

再次说明:我是悲观的乐观主义者。

没有悲观的看清自己、认清形势、想通方法,“乐观”从哪里来?

H100、H200、MI300X、Gaudi 2一个比一个能打,弯道超车有没有不知道,差距越拉越大,应该是“行业共识”。

虽然,我们都有一颗不服输,不认命的心。

从架构创新到软硬件结合的差距,叠加“实体名单”的虎视眈眈,在”绝对实力”层面竞争可以留在规划中,但是,企业先要生存下去。这两年融资有多难,不用多说吧,年头见投资人见尾,就像给“行业大客户”送测一样🤐。

如何在保证供应链安全、产能可控的前提下,保持最大程度的“竞争”优势似乎是应该考虑的问题。

你有HBM3e,你能上3nm工艺,你很强,但是你死贵死贵死贵死贵的。

我只有GDDR6,我只用得起12nm,咬咬牙也能上7nm工艺,但是我能把有限的资源的理论性能都发挥出来。

而且,这样玩,我有成本优势啊。

两相比较,在不那么追求极致的场景下,我是不是能有一定比较优势,这些市场可能才是主打市场。

到此处有人可能会喷:你前面都要等“三级RAM抽象大DRAM了”,反手又说

GDDR6也行,咋啥话都给你说了?回答就是:前面是理想,是猜测,是预期,是想看看打败魔法的魔法是否存在。

后面是现实,生活与社会的毒打早就教会了我要认清现实。

ChatGPT刚火爆的时候,全世界都有“奇点到来”的错觉,疯狂上车LLMs,钱不是问题,问题是抢不到H100,等冷静了,发现用三百万的一个土豪金的铁盒子做日常使用,实在是太烧包了。那么自然会去考虑什么叫:T*D的性价比。

今天下午小米汽车的发布会,朋友圈看到一张图:

在电车香还是CUDA香?中,我提到“三大件的范式革命”给了传统国产油车和电车新势力“弯道”的机会。

我一直觉得走“兼容CUDA”这条路,某种意义上来说就如当年国产车的“皮尺部”一样,形似容易,神似呢?

前面提到的MI300X的1.2倍的数据,是AMD在GPU的并行计算领域没有技术积累还是ROCm“不兼容”CUDA,还是芯片的“账面”数据没有遥遥领先?

后发者,难免会陷入领先者有意无意制造的各种陷阱。

不知道大家下过大雪后跑过高速没有,最稳的开法一定是:跟着前车留下的“车辙”走,但是,如果遇到前车忽快忽慢,怎么办,是就这样跟着还是怎么找个机会超过前车?

显然是找个视线良好,路面情况能判断清楚的路段,走一条新车辙出来。

既要,又要,还要这种好事显然不现实,那么是不是聚焦到只要,就能。

大模型给了最好的“弯道”,对于推理,既然大家都要“手搓kernel”,事实上兼容不兼容CUDA无所谓,要性能最后还是依然要走到手搓的OP去。即使NVIDIA的FasterTransformer也不能指望CUDA与nvcc能提供免费的性能收益,该手搓还是必须手搓,不丢人。

希望,24~25年,国产AI芯片圈子,真有借着大模型机会脱颖而出的。

当然,也不希望看到还在“皇帝的新装”自嗨的戛然而止。

年头岁尾,还是不能免俗的。

以下祝福来自ChatGPT的创作与Gemini的润色。

在这个充满挑战与机遇的时代,愿我们像处理器中的智能核心一样,不断攀登技术高峰,追求卓越。

愿新的一年里,我们的思维像并行计算一样高效,创新如同AI加速芯片般日新月异。

愿我们在AI芯片的研发的征途中,不断实现新的突破,创造更多令人惊叹的成就。

祝大家新年快乐!

在新的一年里,工作顺利,生活幸福,身体健康,无裁员之忧(这是我加的)!

欢迎加我的微信“doubtthings”,欢迎交流与探讨。

欢迎关注我的公众号“书不可尽信”,原创文章第一时间推送。